فایل Robots.txt وظیفه هدایت و راهنمایی ربات های خزنده گوگل در هنگام بررسی صفحات سایت ها را به عهده دارد. این فایل، در واقع یک فایل متنی بوده که اجازه دسترسی به صفحات سایت را به ربات های خزنده گوگل می دهد.

البته خاطرتان باشد که شما با نوشتن دستوراتی در این فایل می توانید به ربات ها بفهمانید که کدام قسمت های سایت را بررسی کنند و کدام قسمت را نمی توانند بررسی کنند. از آنجایی که در سئو مهم ترین ربات ها مربوط به موتور گوگل هستند، پس منظور ما از واژه ربات ها همان خزنده های گوگل است.

اهمیت فایل Robots.txt برای سایت

بد نیست برخی از دلایل اهمیت این فایل را بدانیم تا ارزش وجود این فایل در ذهن ما دو چندان شود:

- مدیریت ترافیک سایت

در قسمت قبلی به این نکته اشاره شد که ربات ها به صورت پی در پی در حال خزش صفحات سایت ها بوده و آن ها را بررسی می کنند. پس لزوم توجه به ترافیک سایت و عدم پردازش پهنا باند توسط ربات های گوگل، راهی برای کنترل ترافیک سایت و بهبود کیفیت آن در نتایج و افزایش کلیک گوگل است.

- مدیریت Crawl Budget

یکی از موارد با اهمیت در زمینه بهینه بودن یک سایت، Crawl Budget است. این مورد بسیار شبیه به قسمت قبل بوده، چرا که ربات های موتور جستجو روزانه تعداد زیادی صفحه را بررسی می کنند و شما می توانید با کمک فایل ربات مقدار کراول باجت سایت خود را بهینه کنید. در واقع می توان صفحاتی که نیاز به خزیدن ندارند را در فایل Robots.txt مشخص کنید و از این طریق مقدار بودجه ی خزش سایت خود را بهینه کنید.

کراول باجت (Crawl Budget) در واقع تعداد دفعاتی است که گوگل در روز صفحات سایت شما را خزش می کند و مقدار آن با توجه به بزرگی سایت، سلامت سایت و لینک لینک های ورودی به سایت متغیر است. مقدار کراول باجت متغیر است و ممکن است گوگل در یک روز 20 صفحه و روز دیگر 100 صفحه از سایت را خزش کند.

- جلوگیری از نمایش صفحات در نتایج گوگل

شاید برخی از صاحبان سایت و وبمستران علاقه نداشته باشند برخی از صفحات و فایل های موجود در سایت خود را نمایش دهند. به همین دلیل با اعمال دستوراتی در فایل ربات سایت می توان از این امر جلوگیری کرد.

کاربرد های این فایل

همواره دلایلی وجود دارد تا یک متخصص سئو با استفاده از فایل Robots.txt و اعمال دستوراتی از خزش بی رویه ربات های گوگل به سایت خود جلوگیری می کنند. برخی از این موارد را با هم بررسی می کنیم:

- عدم اهمیت یکسان تمامی صفحات سایت

قطعا سایت هایی که دارای صفحات پرتعدادی هستند به این امر واقف هستند که نمی توان تمامی صفحات را مشابه دانست، بنابراین وبمستران همواره در تلاش هستند تا صفحاتی از سایت را به گوگل نشان دهند که از دید خود دارای اهمیت بالایی هستند.

- عدم ایندکس شدن پنل وب سایت در موتور جستجو

درج تمامی اطلاعات و صفحات یک سایت قطعا اتفاق خوب و ایده آلی برای وب مستران نیست. به همین دلیل با اعمال دستوراتی در فایل ربات می توان این مورد را اصلاح کرد.

- عدم ایندکس صفحات با محتوا نا مناسب

باز هم به اصلی ترین مورد در صفحات می رسیم. محتوا در صفحات حرف اول را می زند. طبیعتا تولید محتوا عالی برای همه صفحات یک سایت کاری سخت و زمانبر است. به همین جهت با دستورات داده شده به فایل ربات می توان از بررسی صفحات با محتوا بی کیفیت توسط گوگل جلوگیری کرد.

- محدود کردن درخواست بیش از حد صفحات

پهنای باند و سرعت سایت دو المان مهم در بحث بهینه سازی و قرار گرفتن در صفحه اول گوگل است. اگر سایتی با تعداد صفحات زیاد داشته باشید که ربات ها همواره در حال بررسی این صفحات هستند، طبیعتا با مشکل سرعت و ترافیک بالا پهنا باند مواجه خواهید شد، لذا وجود این فایل برای کنترل این درخواست ها ضروری است.

محدودیت های Robots.txt چیست؟

شاید جالب باشد که بدانید با اینکه فایل Robots.txt دارای کارایی بسیاری است، اما با محدودیت های جزئی مواجه است که به صورت مختصر به آن ها اشاره می کنیم:

- دستورات برای همه ربات ها یکسان نیست.

- امکان درک متفاوت دستورات توسط ربات ها وجود دارد.

- امکان ایندکس شدن صفحه با وجود جلوگیری از آن در فایل txt وجود دارد.

اجزا تشکیل دهنده این فایل چیست؟

- User-agent: برای مشخص کردن رباتی که دستورات برای آن نوشته شده است.

- Disallow: بخشهایی که ربات اجازه درخواست یا بررسی آن را ندارد.

- Allow: بخشهایی که ربات ها مجاز به درخواست و بررسی هستند.

- Sitemap: استفاده از فایل txt برای نشان دادن آدرس فایل نقشه سایت به رباتها استفاده می شود.

مشخص کردن دستورات

مشخص کردن ربات با User-agent

از این دستور برای هدف گیری یک ربات خاص استفاده میشود و از آن میتوان به دو شکل در فایل Robots.txt استفاده کرد.

اگر قصد دارید به تمام رباتهای خزنده یک دستور مشابه بدهید، کافی است بعد از عبارت User-agent از علامت ستاره (*) استفاده کنید. مانند مثال زیر:

*:User-agent

اما اگر میخواهید تنها به یک ربات خاص مانند ربات گوگل (GoogleBot) دستور خاصی را بدهید، دستور شما باید به شکل زیر نوشته می شود:

User-agent: Googlebot

مشخص کردن صفحات و بخشهای غیرمجاز با Disallow

همانطور که از اسم آن مشخص است با این دستور شما به ربات ها می فهمانید که به کدام قسمت ها در سایت مراجعه و آنها را بررسی نکنند. به مثال زیر توجه کنید:

فرض کنیم که تمام این تصاویر را به درون فولدری به نام pictures منتقل کردهاید. برای آنکه به گوگل بگویید که این تصاویر را ایندکس نکند، باید دستوری مانند زیر را بنویسید:

*:User-agent

Disallow: / pictures

مشخص کردن بخشهای مجاز برای رباتها با Allow

فرض کنید در فولدر pictures تصویری وجود دارد با نام anizlogo.png که می خواهیم ربات های خزنده آن را ایندکس کنند. در این حالت دستوری که باید در فایل ربات نوشته شود به صورت زیر خواهد بود:

*:User-agent

Disallow: /pictures

Allow: /pictures/anizlogo.png

نقشه سایت (sitemap)

گوگل برای سئوکارها چند راه برای دسترسی به نقشه سایت گذاشته است. یکی از این راه ها نوشتن آدرس سایت مپ در فایل Robots.txt است.

با استفاده از آدرس زیر می توانید نقشه سایت هر وب سایتی را مشاهده کنید:

https://example.com/sitemap.xml

چگونه فایل ربات robots.txt بسازیم؟

اگر فکر میکنید نوشتن فایل ربات کار پیچیده و سختی است باید بگوییم که اشتباه فکر کردید، زیرا بسیار ساده و کوتاه می توانید این فایل با ارزش را بنویسید.

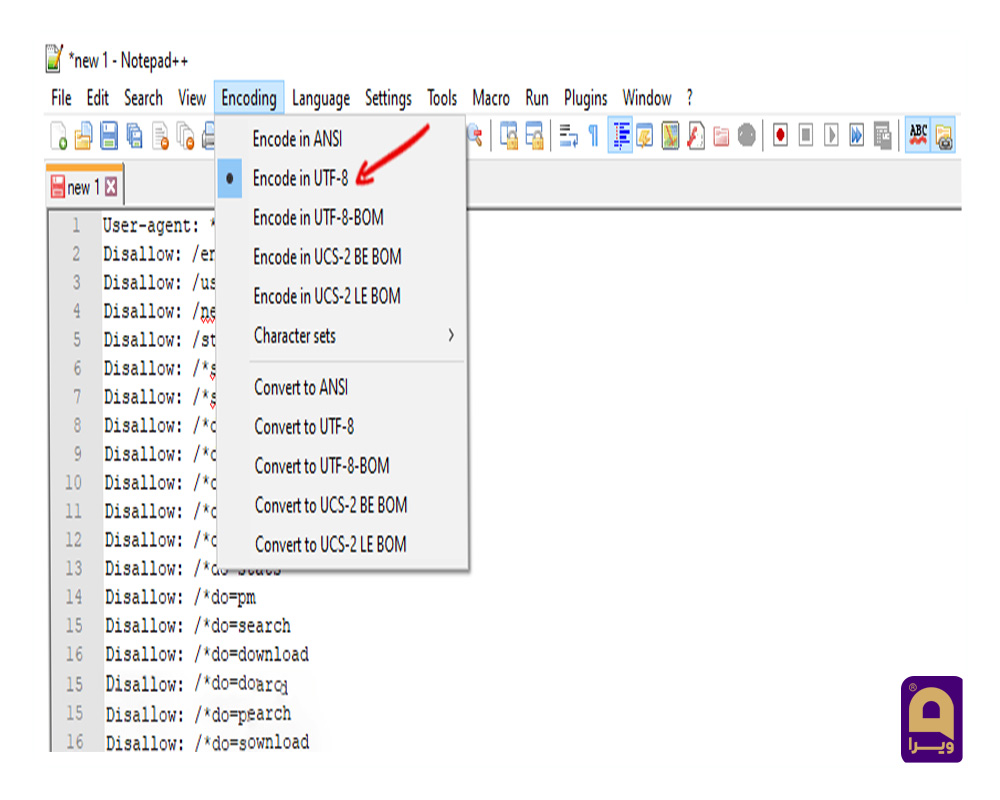

فقط کافیست نرم افزاری مانند Notepad که فایل ها را با پسوند txt ذخیره می کند را در سیستم خود داشته باشید. برای ساخت فایل Robots.txt فقط یک فایل txt جدید ایجاد کنید. فرمت یا انکودینگ فایل حتماً باید UTF-8 باشد.

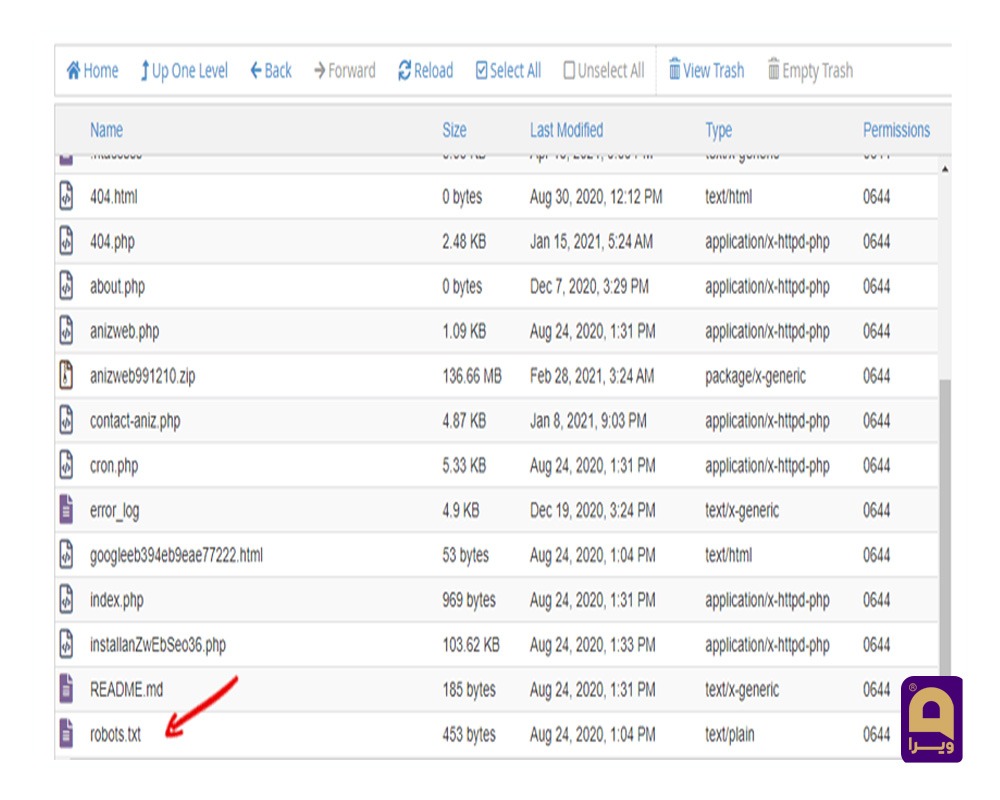

در این فایل طبق دستوراتی که در بالا گفته شد، محدودیت و دسترسی ها را برای ربات ها مشخص کنید.حال که با ساختن آن آشنا شدید باید آن را داخل هاست خود بارگذاری کنید. برای اینکار فقط کافیست فایل ها را در Root قرار دهید و اصلا نباید آن ها را در صفحات یا دایرکتوری ها قرار دهیم.

همچنین می توانید با استفاده از دستور زیر فایل ربات خود را تست کنید:

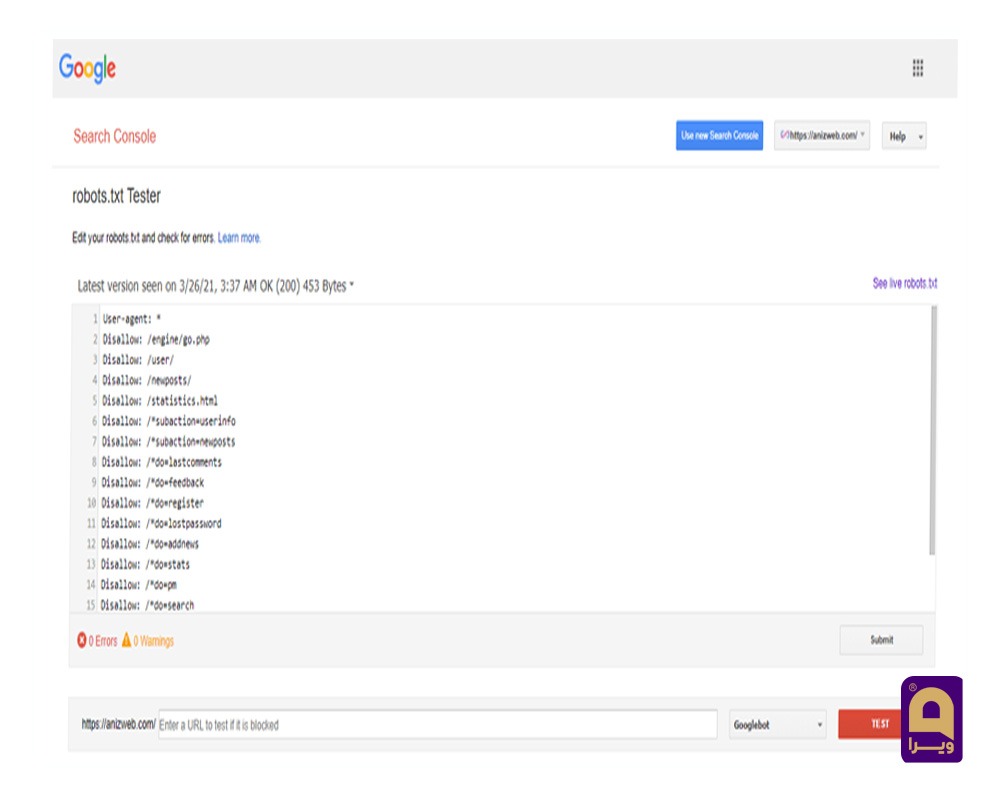

برای این منظور ابتدا وارد سایت Google Search Console شوید. روی بخش Robots.txt Tester کلیک کنید. گزینه Test را انتخاب کنید. اگر فایل به درستی بارگذاری شده باشد گزینه قرمز رنگ تست به رنگ سبز تغییر خواهد کرد.

محل قرار گیری فایل Robots.txt کجاست؟

اگر به دنبال این فایل هستید خیالتان راحت کار چندان پیچیده ای برای پیدا کردن آن ندارید. فقط کافیست از حالت دستوری زیر استفاده کنید:

https://example.com/robots.txt

تاثیر این فایل بر سئو سایت

- جلوگیری از محتوا تکراری: اگر صفحاتی با محتوا یکسان در سایت خود داشته باشید بلافاصله ربات ها تشخیص می دهند و برای شما شناسایی می شود.

- پنهان سازی قسمت هایی از سایت: بسیاری از متخصصان سئو علاقه ای به افشا شدن قسمتی از سایت خود در نتایج گوگل ندارند، به همین جهت با استفاده از فایل ربات آن را مخفی می کنند. مانند بخش رزومه ی افراد در سایت

- بهینه سازی Crawl Budget

- بهبود سرعت سایت: یکی از موارد مهم در سئو سایت بحث سرعت سایت است. فایل txt با بهینه کردن خزش ربات های گوگل در سایت به سرعت سایت کمک کرده و آن را بهبود می دهد.