در سالهای اخیر گوگل اقدام به تهیه و انتشار الگوریتم های خود کرده است و با استناد به این مطلب پی میبریم که گوگل سعی میکند خود را آپدیت و بهروز نگه دارد.

یکی از مزایای استفاده از الگوریتم گوگل این است که گوگل بتواند در شرایط مختلف واکنشهای متفاوتی را از خود نشان دهد و درنتیجه بهترین خدمات و سرویسها را برای کاربرانش به ارمغان آورد. اگر سئو کار هستید یا میخواید که سئو سایت خودتون به زودی آغاز کنید مطمئنا با چنتا از الگوریتم ها آشنا شده اید.

در این مقاله الگوریتم های اصلی و جزئی مورد بررسی قرار میگیرند که میتوانند در سئو یک سایت کمک فراوانی به شما کنند تا هیچ وقت از مسیر اصول گوگل خارج نشوید.

الگوریتم گوگل چیست؟

الگوریتم گوگل درواقع شامل دستورالعملهایی است که گوگل بر اساس آنها تصمیم میگیرد که صفحه شما در کدام رتبه قرار بگیرد؛ در نتیجه تاثیر به سزایی در سئو سایت دارد.

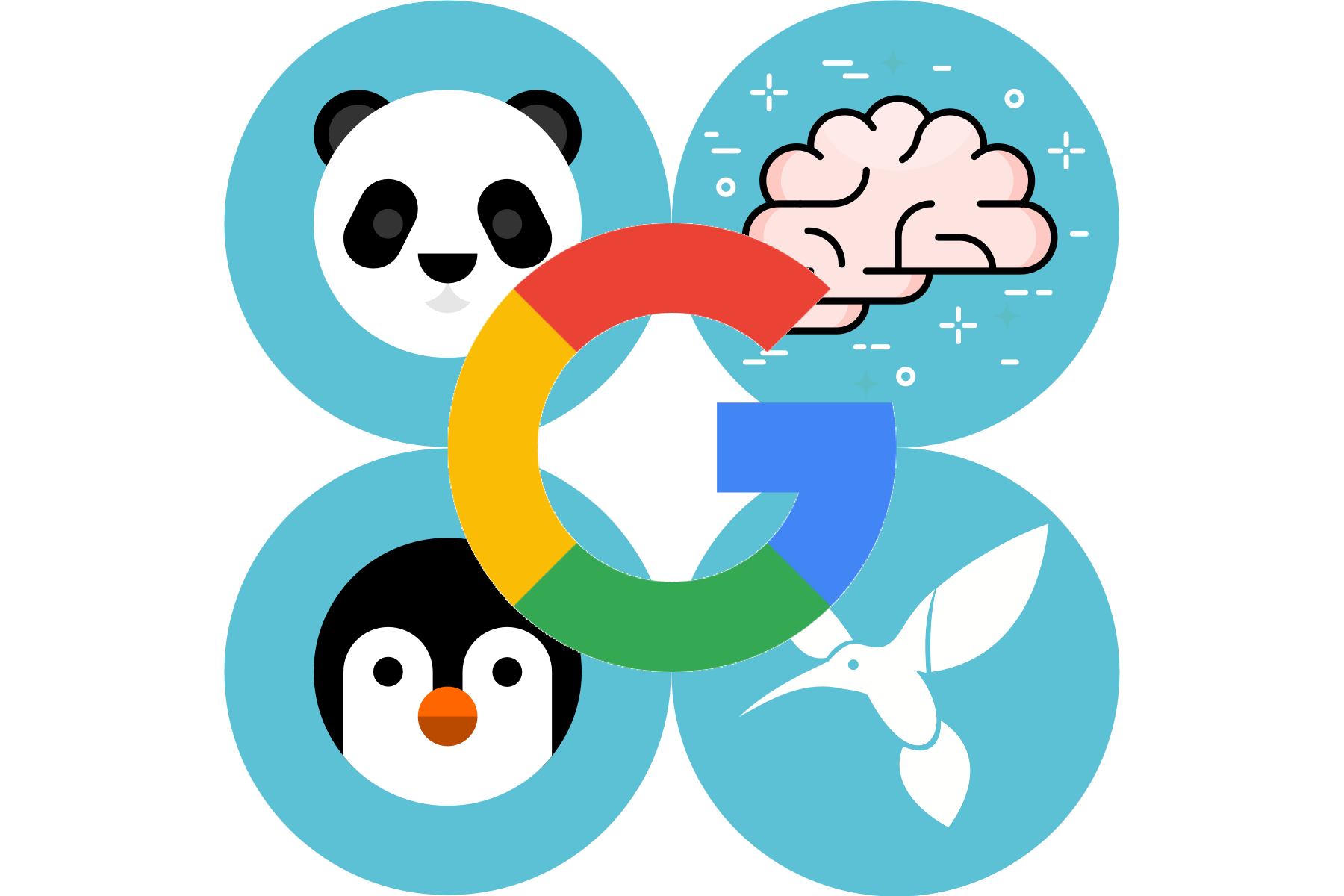

الگوریتمهای گوگل به دو دسته اصلی تقسیمشدهاند: الگوریتمهای دسته اول یا اصلی درواقع جزو هسته اصلی گوگل هستند و بر اساس پارامترهای مختلف سایتهای اینترنتی را رتبهبندی میکنند.

الگوریتمهای دسته دوم بهصورت جانبی برای شناسایی سایتهای مرجع و پرمحتوا از سایتهای اسپم و بیمحتوا یا بهبود نتایج جستجو و بهینهسازی درخواستهای کاربران استفاده میشوند.

| نام الگوریتم | سال انتشار | هدف الگوریتم | توضیحات |

|---|---|---|---|

| PageRank | 1996 | رتبهبندی صفحات | اولین الگوریتم گوگل که براساس لینکهای ورودی به صفحات وب، آنها را رتبهبندی میکرد. |

| Panda | 2011 | کاهش رتبه محتوای با کیفیت پایین | هدف این الگوریتم کاهش رتبه سایتهایی با محتوای کپی و کمکیفیت بود. |

| Penguin | 2012 | مبارزه با اسپم و لینکسازی مصنوعی | با تمرکز بر لینکسازی غیر طبیعی و اسپم، رتبه وبسایتهایی که به این روشها متوسل شده بودند، کاهش یافت. |

| Hummingbird | 2013 | بهبود درک مفهوم جستجوها | این الگوریتم به گوگل کمک کرد تا جستجوها را بهتر درک کند و به جای تمرکز صرف بر کلمات کلیدی، مفهوم کلی جستجوها را بفهمد. |

| Pigeon | 2014 | بهبود جستجوهای محلی | الگوریتمی که به بهبود نتایج جستجوهای محلی کمک میکند و عوامل مانند فاصله و مکان جستجو را در نظر میگیرد. |

| Mobilegeddon | 2015 | بهبود نتایج جستجوی موبایل | این الگوریتم صفحات وبی که بهینه برای دستگاههای موبایل نبودند را جریمه کرد و صفحات واکنشگرا را ارتقاء داد. |

| RankBrain | 2015 | هوش مصنوعی و یادگیری ماشینی | استفاده از هوش مصنوعی برای کمک به الگوریتمهای گوگل در تفسیر بهتر جستجوهای پیچیده. |

| Fred | 2017 | مبارزه با محتوای کمکیفیت و پر از تبلیغات | سایتهایی که به طور عمده بر درآمد تبلیغاتی تمرکز کرده و محتوای کمارزشی ارائه میکردند، تحت تأثیر این الگوریتم قرار گرفتند. |

| BERT | 2019 | بهبود درک زبان طبیعی | الگوریتم BERT به گوگل کمک میکند تا جستجوهای کاربران را بهتر درک کند و مفهوم عمیقتری از جستجوها به دست آورد. |

| Core Updates | بهروزرسانیهای متعدد | بهبود کلی کیفیت نتایج | این بهروزرسانیها به منظور بهبود عملکرد کلی موتور جستجو و نمایش نتایج با کیفیت بهتر در فواصل زمانی مختلف منتشر میشوند. |

این الگوریتمها دو هدف مهم را دنبال میکنند:

- کاهش رتبه سایتهای بی کفیت و اسپم

- افزایش رتبه سایتهای باارزش و کاربر محور

معرفی الگوریتم گوگل

قبل از اینکه به بررسی هرکدام از “الگوریتمهای گوگل” بپردازیم، باید این را بدانیم که چه هستند و چه سیستمی باعث اجرای آنها میشود.

بهطورکلی این الگوریتمها بهنوعی یک سیستم ریاضی هم محسوب میشود که در دل آنها میتوانید به معرفی و بررسی موضوعات دیگر بپردازیم و درنهایت به یک جمعبندی و بررسی نهایی برسیم. اجازه دهید با یک مثال این مطلب را بهتر انتقال دهیم.

شخصی قصد دارد به یک آدرس خاصی برود و از شما سؤال میکند که از چه راهی میتواند به مقصد برسد. در این زمان اتوبوس، مترو و پیاده رفتن گزینههای جواب هستند با این تفاوت که زمان رسیدن آن متغیر است. ما در اینجا هر مسیری را یک الگوریتم میشناسیم.

شما میتوانید با رعایت قوانین و مقررات این الگوریتمها، رتبه سایتتان را ارتقا دهید.

الگوریتم پیج رنک ( Page Rank )

PageRank یکی از مهمترین و قدیمیترین الگوریتمهای گوگل است که توسط بنیانگذاران آن، لری پیج و سرگی برین، در سال 1996 توسعه یافت.

این الگوریتم به منظور ارزیابی اهمیت صفحات وب براساس لینکهای ورودی به آنها طراحی شد. ایده اصلی PageRank این است که هر لینکی که از یک صفحه به صفحه دیگر داده میشود، نوعی رأی به حساب میآید.

اما همه رأیها به یک اندازه ارزش ندارند؛ صفحاتی که خود دارای لینکهای ورودی بیشتری هستند (و معتبرتر محسوب میشوند)، رأیهای با ارزشتری به صفحات دیگر میدهند.

در نتیجه، صفحات با لینکهای ورودی بیشتر و با کیفیت بالاتر، رتبه بالاتری در نتایج جستجو دریافت میکنند. این الگوریتم پایهای برای رتبهبندی صفحات وب در موتور جستجوی گوگل بود و تأثیر بسیار زیادی بر نحوه نمایش نتایج جستجو داشت.

پاندا (Google Panda)

در ابتدا این الگوریتم بانام Farmer ارائه شد. طبق آن گوگل در محتواها دقت میکرد و سعی میکرد باکیفیتترین مقالات را نمایش دهد. ولی بههرحال در سال 2011 الگوریتم پاندا معرفی شد که نامش از سازنده الگوریتم گرفتهشده بود. علت ارائه این الگوریتم این است که سایتهای بیکیفیت و غیرقابل قبول مورد شکایت جامعهی جهانی قرارگرفته بود. یکی دیگر از علل ساخت این الگوریتم، خنثی کردن سازی فعالیت سئو کلاه خاکستری و سئو کلاه سیاه بود.

محتواهایی که ازنظر الگوریتم پاندا نامناسباند:

- محتوای نازک (Thin Content): مقالاتی ضعیف با متن و منابع بسیار کم هستند و در هر مقاله فقط چند جمله وجود دارد.

- محتوای تکراری (Duplicate Content): زمانی که شما چندین مقاله را با متنهای مشابه که در آنها فقط تغییرات جزئی را اعمال کردید، منتشر میکنید، وبسایت شما با مشکلات محتوای تکراری مواجه میشود.

- محتوا باکیفیت پایین (Low-quality Content): صفحاتی که ارزش کمی برای کاربران دارند، زیرا اطلاعات عمیقی ندارند.

- عدم تطابق جستجو با محتوا: صفحاتی که عنوان آنها با محتوای آنها یکی نیستند و زمانی که کاربر روی عنوان موردنظر کلیک میکند، با محتوایی غیر مرتبط یا تبلیغاتی مواجه میشود.

نکته: اگر در وب سایت شما افت ناگهانی میزان بازدید و یا رتبهبندی جستجو اتفاق افتاد به این دلیل است که احتمالاً توسط الگوریتم پاندا جریمهشدهاید.

اقداماتی که برای بهبود دوباره سایتتان از پاندا میتوانید انجام دهید:

- کنار گذاشتن روشهای نادرست تولید محتوا

- بازنگری محتوای وب سایت برای کیفیت، سودمندی، ارتباط، قابلیت اطمینان و اقتدار

- اطمینان از مطابقت محتوای صفحه با درخواست کاربر

- حذف یا ویرایش محتوای تکراری

- تجدیدنظر در محتوا بهطوریکه صفحات تحت سلطه تبلیغات یا پیوندهای وابسته نباشند.

بوستون (Google Boston)

این الگوریتم در سال 2003 منتشر شد. که در واقع اولین بهروزرسانی و آپدیت الگوریتمهای گوگل بود و در یک اجلاس علمی مهندسی معرفی شد. یکی از سیاستها و اهداف این الگوریتم به این صورت بود که در طی فرآیند کار، مقالات و مطالب منتشرشده را ماهانه بررسی کند و در آپدیت بعدی، مقالات بهصورت روزانه بررسی میشوند و پس از آن بیشتر کاربران مقالات خود را سعی میکنند روزانه انتشار دهند.

فلوریدا (Google Florida)

تاریخ انتشار این الگوریتم به نوامبر سال 2003 برمیگردد و میتوان گفت که این الگوریتم طراحان سایت را تحت تأثیر قرارداد و به وبمستران این آموزش را داد که از چه روشی استفاده کنند تا بتوانند در ترافیک ارگانیک کاربر جذب کنند. یکی از روشهای این الگوریتم این بود که از لینک داخلی و خارجی و کلمات کلیدی استفاده کنند.

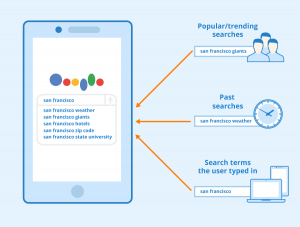

شخصیسازی نتایج جستجو (Google Personalized Search)

ژوئن سال 2005 تاریخ انتشار این الگوریتم بود. یکی از قابلیتهایش این بود که تاریخچه جستجوها را ذخیره میکرد و کاربران میتوانستند در زمان دیگری از آنها برای جستجوهای بعدی خود استفاده کنند.

جستجوی جهانی (Google Universal Search)

یکی از اهداف این الگوریتم راحتی کاربران گوگل بود که در می 2007 معرفی شد. این الگوریتم جزو بهترین آپدیتهای گوگل هم شناخته میشود. قبل از آمدن این الگوریتم، کاربران در جستجوهایشان نتایجی مانند اخبار، کتابها، تصاویر و موارد مشابه مشاهده میکردند. با آمدن الگوریتم Universal، جستجوها از یکدیگر تفکیک میشدند و پس از آن بود که تصاویر، اخبار و… جدا از هم نمایش داده شدند.

پیشنهاد گوگل (Google Suggest)

گوگل این الگوریتم را به مدت 4 سال آزمایش میکرد و بالاخره در آگوست سال 2008 این الگوریتم را معرفی کرد. هدف این الگوریتم استفاده از کوئری (Query) یا عبارات کلیدی بود و عملکردش به این صورت بود که بهجز متن جستجوی خود، بتوانند از کلمات کلیدی محبوب نیز مطلع شوند و بهترین انتخاب را داشته باشند و مقدمهای برای الگوریتم Google Instant که زمان ارائهاش سال 2010 بود، محسوب میشد.

کافئین (Google Caffeine)

سیستم ارائه محتوا در گوگل و مدل لایهای، روش جستجوهای گوگل بود تا اینکه گوگل از الگوریتم کافئین پردهبرداری کرد. تا قبل از این سایتهایی که رتبه بالایی داشتند در جستجو میآمدند و جایی برای سایتهای تازه تأسیس نبود. اینگونه بود که گوگل برای حل این مشکل در سال 2009 این الگوریتم را معرفی کرد. ولی راهاندازی و کار با آن به ژوئن سال 2010 موکول شد. و دیگر سایتها لایهبندی نبودند و درواقع به همه سایتها اجازه دیده شدن در نتایج جستوجوی کاربران داده شد.

پنگوئن (Google Penguin)

این نوع الگوریتم را میتوانیم تراشکار گوگل بنامیم. وظیفه الگوریتم پنگوئن این است که سایتهایی که با روشهای تقلبی و غیرقانونی رتبههای بالا را از آن خودکردهاند، شناسایی و سپس رتبههایشان را کاهش دهد. سایتهای متخلف با روشهایی نظیر استفاده زیاد از کلمات کلیدی، لینکهای غیرمجاز و اسپم قصد تصاحب رتبههای خوب رادارند و باعث میشوند آمار بازدید و ترافیک و ارگانیک را کم کنند.

بنابراین گوگل برای مقابله با این وبسایتها که معمولاً از سئو کلاهسیاه استفاده میکنند، الگوریتم پاندا را آپدیت و بهروزرسانی میکند. با توجه به مطالب گفتهشده، طراحان وبسایتها چارهای جز اینکه مقالات باکیفیت تهیه کنند و از آن مهمتر اینکه شرایط و ضوابط گوگل را نقض نکنند تا در کنار این، باعث رشد تجربه کاربری سایتها شوند نداشتند.

پنگوئن دو عمل خاص را هدف قرار داده است:

- طرحهای پیوند (Link Schemes): توسعه، خرید یا خرید بک لینک از وب سایت های بیکیفیت یا غیر مرتبط.

- پر کردن کلمات کلیدی (Keyword Stuffing): استفاده از تعداد زیادی کلمات کلیدی یا تکرار کلمات کلیدی.

الگوریتم Google Knowledge Graph

هدف از ساخت این الگوریتم آن است که کسانی که به دنبال مطالب و مقالات علمی هستند، بسیار سریع و آسانتر از قبل به آنها دست پیدا کنند. زمان رونمایی از این الگوریتم به ماه می سال 2012 برمیگردد. گوگل در بیانیهای اعلام کرده است که در راستای اینکه جستجوگران از جهان واقعی و روابط با یکدیگر مطلع شوند، اقدام به ساخت این الگوریتم کرده است.

هنگام شروع به کار این الگوریتم، آمار و اطلاعاتی در حدود 500 میلیون شی خاص را داشته است. برای اینکه این مفهوم را بهخوبی درک کنید، پیشنهاد میکنیم واژه «مدیر وب» را در گوگل جستجو کنید. در هنگام مشاهده نتیجه علاوه بر اینکه آمار را مشاهده میکنید، در سمت راست یک نمودار شامل اطلاعات تکمیلی را نمایش میدهد که میتواند حاوی اطلاعاتی مانند نوع کسبوکار، حوزه فعالیت کلمه کلیدی و آدرس است.

الگوریتم گوگل مرغ مگسخوار (Google Hummingbird)

پس از گذشت زمان و با بررسی و پژوهش بر روی نتایج، گوگل به این نتیجه رسید که کاربران در واکنش به کوئری ها بسیار خاص و جالب عمل کردهاند. گوگل از نتایج دریافت که کاربران مایل هستند که فقط سراغ یک عبارت یا چند کلمه بروند و متوجه شد که در هنگام نمایش جستجو هم حساسیت بسیار بالایی دارند و دوست دارند که نتایج بسیار دقیق و نزدیک باشد.

الگوریتم مرغ مگسخوار در سال 2013 میلادی معرفی شد. باید بگوییم که به نسبت سایر مدلهای پیشین، تغییر چندانی نداشت ولی بسیار خوب و کاربردی عمل میکند که باعث جلبتوجه بسیاری از کاربران شد. به کمک این الگوریتم گوگل موفق شد نتایج خود را تا 90 درصد نزدیک به نظر مشتری کند.

مرغ مگسخوار را میتوان پل ارتباطی بین شیوههای قدیمی و سئو جدید دانست که میخواهد با استفاده از کلمات خود به زبان طبیعی کاربران صحبت کند. وبسایتهایی که بهطور ماهرانه پاسخ به محبوبترین سؤالات عمومی را شناسایی و منتشر میکنند، میتوانند بهعنوان منابع مرتبط با موضوعات خاص توسط Google انتخاب شوند.

الگوریتم گوگل کبوتر

اسم این الگوریتم به دلیل تمرکز بر سئو محلی یا لوکال انتخابشده است زیرا الگوریتم کبوتر، متمرکز بر ارائه نتایج جستجوی باکیفیت و مرتبط با مکان جستجو کننده است. در این الگوریتم، سئو محلی یا لوکال اهمیت زیادی پیداکرده است. برای مثال کسبوکارها میتوانند با ثبتنام و آدرس شرکت خود در فهرست کسبوکارهای گوگل، شانس پیدا شدنشان را در نتایج گوگل افزایش دهند.

رنک برین

الگوریتم رنک برین در اکتبر 2015، بر پایه هوش مصنوعی ایجاد شد. رنک برین به شما نزدیکترین پاسخ را در قبال جستجو بیان می نماید. علاوه بر این بر اساس رفتار کاربران رتبهبندی نتایج جستجو را بهینهسازی کند.

بسته به پیچیدگی و مدرن بودن مهارتهای شخصی شما در سئو، RankBrain ممکن است یک تغییر جزئی یا عمده در نظریهها و عملکردهای شما باشد.

الگوریتم گوگل گورخر

این الگوریتم به بررسی فروشگاههای اینترنتی میپردازد و درصورتیکه نکات مهم چه در طراحی و چه در عملیات خرید در آنها رعایت شده باشد، ازنظر الگوریتم گورخر امتیاز بالایی به دست خواهند آورد. نکاتی مانند دستهبندی مناسب، داشتن مراحل مشخص برای خرید، کوپن تخفیف و هرچه سایتی را شبیه به فروشگاه اینترنتی میکند.

رقص گوگل

یکی از اتفاقات عجیب در سئو، جهشهای ناگهانی در رتبهبندی نتایج گوگل است. که باعث میشود جایگاه شما در یک یا چند عبارت کلیدی رشدی ناگهانی و مثبت را تجربه کند. این تغییرات معمولاً توسط الگوریتم رقص گوگل ایجاد میشوند و هدف آنها بررسی میزان رضایت کاربر از آن صفحه است.

واقعیتهایی جالب درباره الگوریتمهای گوگل

- الگوریتمهای Google تقریباً 500 بار در سال تغییر میکنند.

هرساله 500-600 بهروزرسانی انجام میشود که برخی از آنها بسیار جزئی هستند. تغییرات الگوریتمها در سالهای اخیر بهسرعت افزایشیافته است. زیرا تعداد کاربران افزایشیافته است و با نگهداری اطلاعات مناسب از نیازهای افراد، بهبودهایی نیز به آن اضافه میشود.

- هدف اصلی الگوریتمها، ارائه یک تجربه کاربری عالی است.

Google اطمینان حاصل میکند که با بهترین کیفیت نتایج جستجو را دریافت میکنید. برای این کار اولین و مهمترین چیز حذف یا عبور از محتوای هرزنامه است. به همین دلیل در هر صفحه نتایج جستجو از تبلیغات بیشتر است.

- الگوریتمها، جستجوی تصویر را نیز در نظر میگیرند.

ازآنجاکه امروزه جستجوهای تصویر افزایشیافته است، بنابراین نیاز به شناسایی تصویر نیز افزایشیافته است. الگوریتمها با تطبیق تشخیص چهره و شناسایی جزئیات کوچک در مورد عضلات صورت و هندسه صورت، جستجوی تصویر را نیز بهتر میکنند. این الگوریتمها بهاندازه کافی هوشمند هستند که میتوانند اشیا موجود در یک تصویر را تشخیص دهند و جستجو را به هم مرتبط کنند.

- الگوریتمها دادههای بیربط و نویزها را حذف میکنند.

الگوریتمهای گوگل همچنین برای رد کردن دادههای بیربط مورد جستجو یا خطاهای نوشتاری توسط کاربران، طراحی و بهروزرسانی شدند، بدین معنی که کلمات دارای غلط املایی را با کلمات تقریباً مشابه آنها شناسایی میکنند. در جستجوی صوتی با صدای بیربط غیر از کاربران، گاهی اوقات جستجو دشوار میشود. الگوریتمها با تمرکز روی تکصدا یا واضحترین و بلندترین صدای ضبطشده توسط دستگاه، بر روی رد کردن آن صداهای بیربط کار میکنند.

نتیجهگیری

با توجه به مطالب گفتهشده به این نتیجه میرسیم که سرعت رشد الگوریتمهای گوگل بسیار زیاد است. و روز به روز شاهد ارائه مدلهای جدید هستیم. گوگل بر این فرض عمل میکند که کاربرانش دانش تخصصی با نحوه جستجو ندارند و بر این اساس الگوریتمها را تولید میکند. به نوعی الویت اصلی گوگل ارائه مطالب مخاطب پسند می باشد. این قوانین نیز به همین منظور پیاده می شود.

الگوریتم ها آپدیت می شوند تا افراد به دنبال دور زدن آن نباشند، همچنین با توجه به شرایط موجود یک سری قوانین مطابق آن آماده کنند. شما نیز برای رسیدن به جایگاه های بالا نتایج جستجو گوگل، نیازمند دانستن و پیاده سازی این الگوریتم ها می باشید.